POR VINICIUS PINTO // AS RAÍZES DA INTELIGÊNCIA ARTIFICIAL: DA MITOLOGIA À REALIDADE

A inteligência artificial (IA) é uma área da ciência da computação que busca criar sistemas capazes de realizar tarefas que normalmente requerem inteligência humana. A IA generativa, por sua vez, envolve a criação de sistemas que podem gerar conteúdo, como texto, imagens e música, de forma criativa e autônoma. Neste artigo, exploraremos as raízes históricas da inteligência artificial e da IA generativa, desde a mitologia grega até os avanços tecnológicos recentes.

Mitologia Grega: Talos, o Guardião de Bronze

Em tempos antigos, antes mesmo da era da eletrônica e da computação, os seres humanos já imaginavam a criação de seres artificiais inteligentes. Na mitologia grega, uma história intrigante emerge, protagonizada por Talos, um gigantesco autômato de bronze. Conforme a lenda, Talos foi forjado por Hefesto, o deus da forja, para proteger a ilha de Creta.

Talos era uma maravilha de engenharia da época, dotado de um intelecto artificial e de poderes extraordinários. Sua missão era patrulhar as costas de Creta e proteger a ilha de intrusos indesejados. Embora essa história remonte a séculos atrás, ela representa uma das primeiras manifestações da imaginação humana em relação à criação de seres artificiais inteligentes.

Para saber mais sobre essa intrigante história e as raízes mitológicas da inteligência artificial, você pode explorar obras clássicas da mitologia grega, como o “Theogony and Works and Days” de Hesíodo ou assistir o filme Jasão e os Argonautas (Jason and the Argonauts, 1963) de Don Chaffey. Embora não seja um tratado específico sobre Talos, eles oferecem uma visão das histórias dos deuses gregos e de suas criações, que incluem seres como Talos.

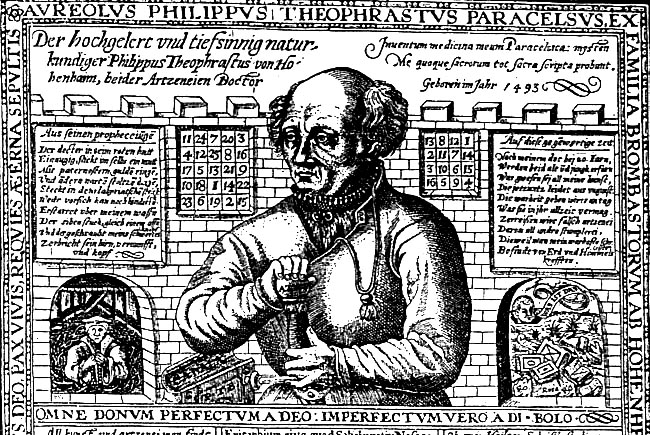

Idade Média: Paracelsus e o Homúnculo

Na Idade Média, um período marcado por sua reverência à alquimia e à magia, o alquimista suíço Paracelsus introduziu uma concepção fascinante: o “homúnculo”. Este conceito se relaciona indiretamente com a inteligência artificial moderna, pois ele representa um exemplo notável do desejo humano de criar seres artificiais.

O homúnculo era uma criatura minúscula, criada por processos alquímicos complexos, e muitas vezes era associada à busca da imortalidade. Embora as práticas alquímicas não tenham levado à criação real de seres, essa ideia reflete a persistente curiosidade humana em relação à criação artificial.

Para explorar mais sobre o conceito do homúnculo e sua influência na época medieval, você pode se aprofundar em obras como “The Chemical Wedding of Christian Rosenkreutz” de Johann Valentin Andreae. Este livro alquímico, publicado no início do século XVII, explora temas relacionados à criação artificial e é uma das fontes que inspiraram a ideia do homúnculo.

Idade Moderna: R.U.R. e a Criação de Robôs

No início do século XX, a imaginação humana foi mais uma vez estimulada por uma peça de teatro revolucionária chamada “R.U.R. (Rossum’s Universal Robots)”, escrita pelo autor tcheco Karel Čapek em 1920. Esta obra não apenas popularizou o termo “robô”, mas também explorou as implicações morais e éticas da criação de autômatos humanóides.

“R.U.R.” é ambientada em uma fábrica onde robôs sintéticos são produzidos em massa. A peça levanta questões profundas sobre a natureza da humanidade, a automação e a responsabilidade que acompanham a criação de seres artificiais. Embora o termo “robô”, palavra derivada do tcheco “robota” – que significa trabalho duro, forçado – , tenha sido cunhado por Čapek e seu irmão, a peça representa uma visão precursora dos desafios éticos que ainda são debatidos no campo da inteligência artificial hoje.

Para entender melhor o contexto histórico e a influência cultural de “R.U.R.”, você pode considerar a leitura da própria peça, “R.U.R.”, escrita por Karel Čapek. Isso proporcionará uma visão direta das ideias e preocupações que permeiam a obra.

Dartmouth College e o Nascimento da IA Moderna (1956)

O ano de 1956 marca um ponto de virada fundamental na história da inteligência artificial, com a realização de uma conferência notável no Dartmouth College. Liderada por John McCarthy, essa conferência deu origem ao termo “inteligência artificial” e marcou o início formal da pesquisa nesse campo emocionante.

A conferência de Dartmouth reuniu visionários e pioneiros que compartilhavam a crença de que as máquinas poderiam ser programadas para realizar tarefas que normalmente exigiam inteligência humana. Essa reunião histórica de mentes brilhantes estabeleceu as bases para o que se tornaria uma disciplina de pesquisa em expansão.

Para uma compreensão mais profunda dos eventos que ocorreram durante essa conferência seminal, você pode explorar o documento original que a propôs, intitulado “A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence” por John McCarthy e outros. Esse documento descreve os objetivos e as expectativas iniciais que impulsionaram a conferência e lançaram as bases da IA moderna.

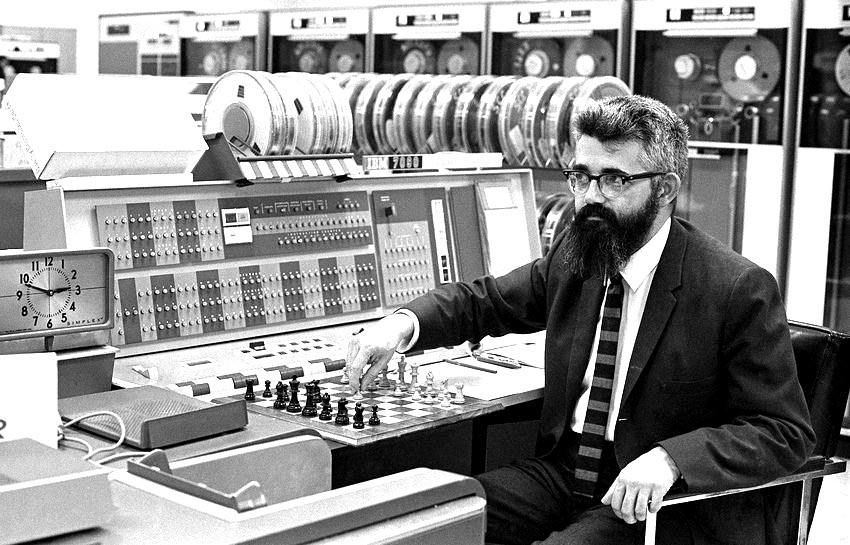

Redes Neurais e Machine Learning

À medida que a IA avançava, a década de 20 do século XX trouxe o desenvolvimento de conceitos cruciais como as redes neurais artificiais, que se tornariam fundamentais para o aprendizado de máquina. Um dos pioneiros nesse campo foi Frank Rosenblatt, psicólogo americano cujo trabalho seminal na criação do Perceptron, é considerado o precursor das redes neurais modernas.

As redes neurais são modelos computacionais inspirados no funcionamento do cérebro humano, e o aprendizado de máquina é uma abordagem que utiliza essas redes para treinar sistemas a partir de dados. Esses avanços permitiram que as máquinas aprendessem com exemplos e realizassem tarefas complexas, desde reconhecimento de voz até jogos.

Para uma exploração aprofundada sobre redes neurais e aprendizado de máquina, você pode mergulhar em livros como “Neural Networks and Deep Learning: A Textbook” de Charu C. Aggarwal. Este livro fornece uma base sólida para compreender o funcionamento das redes neurais e sua aplicação no aprendizado de máquina moderno.

Grandes Pesquisadores e Décadas Subsequentes

Ao longo das décadas, muitos pesquisadores notáveis contribuíram significativamente para o campo da IA. Entre eles, nomes como Alan Turing, Marvin Minsky, John McCarthy e outros se destacam. Suas teorias, inovações e pesquisas foram fundamentais para o desenvolvimento da IA e do aprendizado de máquina.

Alan Turing, por exemplo, é frequentemente lembrado por seu trabalho pioneiro na computação e pela criação da Máquina de Turing, um conceito fundamental na teoria da computação e na IA. Ele também é conhecido por seu papel na quebra do código Enigma durante a Segunda Guerra Mundial.

Para uma visão mais detalhada sobre os principais pesquisadores e suas contribuições para a IA, você pode explorar obras como “Artificial Intelligence: A Modern Approach” de Stuart Russell e Peter Norvig. Este livro oferece uma visão abrangente das ideias e do trabalho de muitos dos principais nomes na história da IA.

Avanços Tecnológicos Recentes e a Lei de Moore

Nos tempos contemporâneos, testemunhamos avanços tecnológicos notáveis, particularmente em empresas líderes como a Boston Dynamics, Microsoft, Tesla, DeepMind e a OpenAI. Essas empresas têm desempenhado papéis cruciais na transformação da ficção científica em realidade, aplicando a IA em uma variedade de setores, como Robótica Avançada, Visão de Máquina, Automação de Processos, Veículos Autônomos, Processamento de Linguagem Natural, e Assistência Virtual para diversas aplicações.

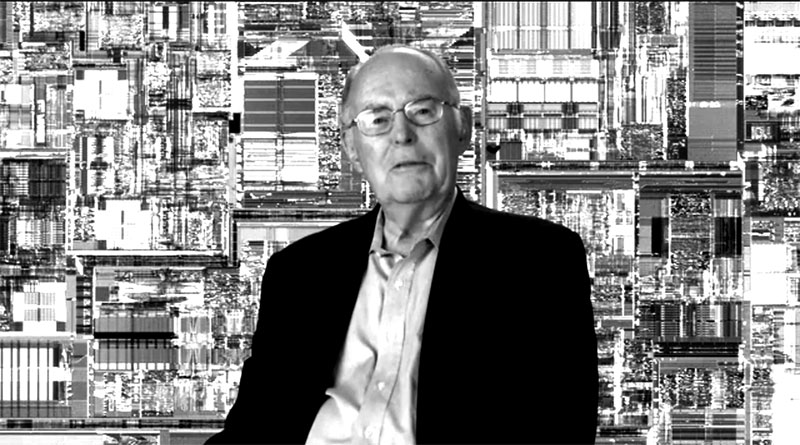

Além disso, um fator fundamental que acelerou o progresso na IA e na robótica avançada é a chamada Lei de Moore. A Lei de Moore, formulada por Gordon Moore, co-fundador da Intel, em 1965, observou que a quantidade de transistores em um chip de computador dobraria aproximadamente a cada dois anos, enquanto o custo por transístor diminuiria. Isso levou a um crescimento exponencial na capacidade de processamento dos computadores, tornando possível a realização de cálculos complexos e a manipulação de grandes volumes de dados em uma escala antes inimaginável.

Essa constante evolução tecnológica permitiu que os algoritmos de IA fossem executados em hardware cada vez mais poderoso, acelerando significativamente o progresso da inteligência artificial. Os avanços em hardware, como unidades de processamento gráfico (GPUs) altamente paralelas e processadores especializados em IA, como os TPUs (Tensor Processing Units), permitiram treinar redes neurais profundas em tempo recorde e impulsionaram a IA a níveis sem precedentes de desempenho.

Além disso, a Lei de Moore também teve um impacto direto na miniaturização de componentes eletrônicos, tornando os dispositivos móveis e sistemas embarcados mais potentes. Isso possibilitou a incorporação de IA em uma ampla variedade de dispositivos, desde smartphones até veículos autônomos e eletrodomésticos inteligentes.

Portanto, é essencial reconhecer a influência da Lei de Moore como um catalisador fundamental do progresso da IA nas décadas recentes. Ela tem sido uma força motriz por trás da capacidade de processamento crescente, tornando possível a execução de algoritmos complexos e impulsionando o desenvolvimento de soluções de IA que impactam diretamente a vida cotidiana.

Já vivenciamos algumas realidades

Nesse cenário de rápida evolução, é essencial reconhecer que a busca por criar máquinas inteligentes não é apenas uma ambição moderna, mas um anseio que se estende por séculos.

Hoje, vemos a realização de vários sonhos ancestrais em formas que nossos antepassados não poderiam sequer imaginar. Assim como muitos filmes de cinema, outrora pura ficção científica, estão gradualmente se tornando realidades acessíveis em nosso cotidiano atual.

No entanto, essas realidades, embora nos fascinem com inovações e possibilidades em constante evolução, também suscitam uma preocupação geral sobre as consequências, positivas e negativas, éticas e morais, que ainda não conseguimos mensurar com precisão… por isso precisamos estar atentos e dispostos a contribuir de forma ativa nestas discussões.

Fonte: AS RAÍZES DA INTELIGÊNCIA ARTIFICIAL: DA MITOLOGIA À REALIDADE, VINICIUS PORTO